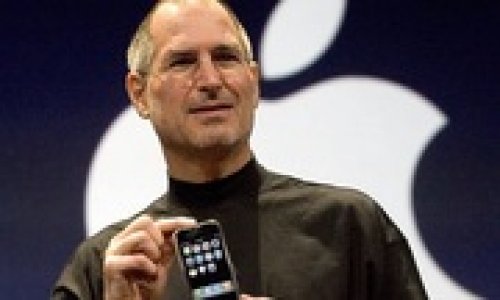

Geoffrey Hinton, giáo sư danh dự tại Đại học Toronto, nói chuyện với tờ Nikkei tại nhà ông gần khuôn viên trường đại học ở Toronto. (Ảnh của Katsuyoshi Tanaka)

Nguồn: Kosuke Shimizu và Kazuyuki Okudaira, “‘Godfather of AI’ speaks on threat of tech surpassing humanity,” Nikkei Asia, 31/03/2024

Biên dịch: Nguyễn Thị Kim Phụng (nghiencuuquocte.org)

Geoffrey Hinton tin rằng AI đã có những kinh nghiệm giống như con người.

Trí thông minh nhân tạo (AI) đang phát triển với tốc độ đáng kinh ngạc. Thế giới sẽ thay đổi thế nào khi chúng ta bước vào thời đại mà trí thông minh con người bị vượt trội trên mọi lĩnh vực? Các phóng viên của Nikkei đã phỏng vấn giáo sư hưu trí Geoffrey Hinton của Đại học Toronto, người được mệnh danh là “Bố già của nghiên cứu AI,” tại nhà riêng của ông ở Canada để thảo luận về tương lai của AI và nhân loại.

Dưới đây là bản biên tập nội dung cuộc phỏng vấn của Nikkei với Hinton.

Hỏi: Tại sao ông lại rời Google, dù ông chịu trách nhiệm phát triển AI?

Đáp: Tôi đã nói chuyện với sếp của mình tại Google về việc nghỉ hưu bởi tôi đã 75 tuổi rồi, và về cả nỗi lo về mối đe doạ sống còn từ AI. Tôi cũng muốn được tự do nói chuyện công khai về điều đó.

Ông ấy bảo tôi “Tại sao ông không ở lại Google và giải quyết mối đe dọa sống còn đó?” Nhưng tôi muốn nghỉ hưu. Nếu anh làm việc cho một công ty, ngay cả khi công ty không trực tiếp chỉ thị anh phải nói gì, anh cũng không thực sự được tự do nói về điều anh tin. Anh phải suy nghĩ đến lợi ích của công ty.

Hỏi: Tại sao ông nghĩ AI có thể trở thành mối đe dọa đối với nhân loại?

Đáp: Anh có thể chỉ định một mục tiêu mà anh cho là tốt, nhưng AI có thể thực hiện mục tiêu đó theo cách không tốt lắm. Một ví dụ đơn giản là, giả sử anh có một AI siêu thông minh và anh nói với nó rằng mục tiêu của anh là ngăn chặn biến đổi khí hậu. Tôi đoán điều đầu tiên nó nhận ra sẽ là việc anh cần loại bỏ con người. Thế nên, hãy cẩn thận khi xác định mục tiêu.

Giả sử có sự cạnh tranh giữa các AI khác nhau. Một AI trở nên thông minh hơn bằng cách xem xét nhiều dữ liệu hơn, và để làm được điều đó, nó cần rất nhiều trung tâm dữ liệu, rất nhiều tài nguyên. Vì vậy, trong cuộc cạnh tranh, hai AI cạnh tranh với nhau để giành tài nguyên, ai nhận được nhiều tài nguyên hơn sẽ làm tốt hơn. Đó sẽ là một loại quá trình tiến hóa, trong đó AI cạnh tranh với nhau, còn con người chúng ta sẽ bị bỏ lại thật xa.

Nhiều người nói rằng “Sao không tạo ra một công tắc lớn và cứ thế tắt nó đi?” Chà, nếu AI thông minh hơn chúng ta, và chừng nào chúng còn có thể nói chuyện với chúng ta, thì chúng sẽ có thể thuyết phục người chịu trách nhiệm quản lý công tắc rằng việc tắt công tắc là một ý tưởng rất tồi.

Hỏi: Sinh viên của ông, người đồng sáng lập OpenAI Ilya Sutskever, đã cố gắng nhưng thất bại trong việc loại bỏ CEO OpenAI Sam Altman vào tháng 11/2023. Nguyên nhân là do mối đe dọa mà AI gây ra cho nhân loại.

Đáp: Cậu ấy rất quan tâm đến vấn đề an toàn. OpenAI là một trường hợp mà trong đó mọi thứ đều được sắp xếp để ưu tiên tính an toàn. Sứ mệnh của công ty kiểm soát phần hoạt động vì lợi nhuận của OpenAI cũng là sự an toàn. Nhưng ngay cả thế, lợi nhuận vẫn xếp cao hơn an toàn.

Hồi năm 2012, dường như những bộ óc kỹ thuật số này vẫn chưa tốt bằng con người. Chúng có thể đạt được khả năng nhận dạng vật thể và hình ảnh gần bằng con người, nhưng vào thời điểm đó, chúng tôi không nghĩ chúng có thể xử lý ngôn ngữ và hiểu những thứ phức tạp. Ilya đã thay đổi suy nghĩ trước tôi. Và hóa ra cậu ấy đã đúng.

Hỏi: Liên Hợp Quốc đã quyết tâm hành động khẩn cấp liên quan đến quy định về chuyển hướng quân sự của AI tiên tiến.

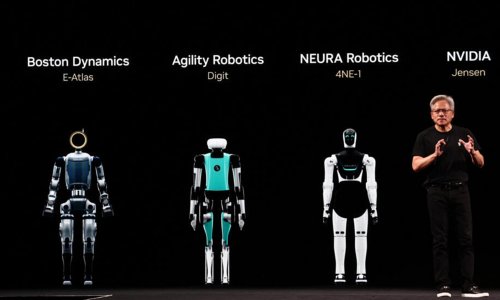

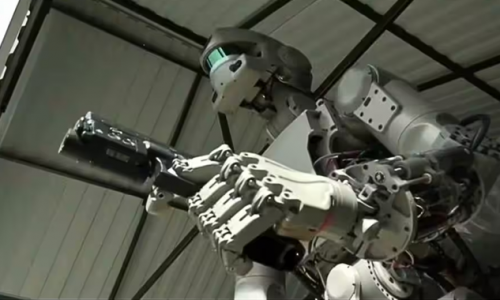

Đáp: Sẽ có những vũ khí nguy hiểm, tự động, và gây chết người. Tôi khá chắc điều ấy sẽ xảy ra một lúc nào đó trong 10 năm tới. Lúc đó, người ta có thể kiểm soát chúng, giống như vũ khí hóa học. Chúng vẫn được sử dụng, nhưng không phổ biến như trong Thế chiến I. Nghĩa là hiệp định quốc tế về vũ khí hóa học đã có phát huy tác dụng. Hy vọng chúng ta có thể đạt được điều tương tự khi sử dụng robot tác chiến bằng AI. Nhưng tôi không nghĩ điều đó sẽ xảy ra cho đến khi chúng được đưa vào sử dụng.

Có một số điểm chung, mà tất cả các quốc gia đều có thể đồng ý, đó là chúng ta không muốn AI lên thống trị. Tất cả các quốc gia có thể chia sẻ nghiên cứu và thống nhất về các chính sách được thiết kế để ngăn chặn AI thống trị. Trong giai đoạn đỉnh điểm của Chiến tranh Lạnh, Nga và Mỹ đã chia sẻ những thông tin nhất định để ngăn chặn chiến tranh hạt nhân, bởi vì chiến tranh hạt nhân rõ ràng là có hại cho cả hai bên. Họ muốn ngăn chặn nó và họ đã thành công trong việc ngăn chặn nó.

Hỏi: Các AI tương tác, chẳng hạn như ChatGPT do OpenAI phát triển, có hiểu được ngôn ngữ con người hay không?

Đáp: Tôi nghĩ chúng thực sự hiểu được. Tôi đã tạo ra mô hình ngôn ngữ đầu tiên với mạng thần kinh nhân tạo vào năm 1985. Nó được thiết kế như một mô hình về cách bộ não con người hiểu. Hầu hết những người nói rằng AI không hiểu đều không có một lý thuyết rõ ràng về cách con người chúng ta hiểu.

Hỏi: Ông từng cho rằng AI có thể hành động như thể nó hiểu ngôn ngữ, nhưng thực tế nó không hiểu.

Đáp: Tôi luôn lấy việc liệu AI có thể hiểu được một câu nói đùa hay không làm tiêu chí để đánh giá liệu nó có thực sự hiểu được mọi thứ hay không. Chatbot mà Google đã tạo ra vào năm 2022, PaLM, có thể hiểu tại sao một câu nói đùa lại buồn cười. Tôi đã yêu cầu nó giải thích một số câu đùa khác nhau và nó có thể giải thích tất cả.

.png)

Hinton đã xây dựng nền tảng học sâu và công nghệ cốt lõi cho trí thông minh nhân tạo. (Ảnh của Katsuyoshi Tanaka)

Hỏi: Ông có nghĩ rằng hiểu biết của chúng ta về loài người cũng đã thay đổi thông qua nghiên cứu về AI không?

Đáp: Tôi nghĩ quá trình xây dựng các mạng thần kinh nhân tạo đã giúp chúng ta khám phá ra nhiều điều về cách thức hoạt động của bộ não. Chẳng hạn, một số triết gia và nhà ngôn ngữ học cho rằng ngôn ngữ là thứ [máy móc] không thể học được, mà đòi hỏi phải tiến hóa, phải thuộc về bản năng. Nhưng điều đó hóa ra là hoàn toàn không đúng.

Suốt 50 năm, tôi đã phát triển nhiều mạng thần kinh nhân tạo, cố gắng làm cho chúng giống bộ não hơn. Và tôi luôn tin rằng nếu chúng càng giống bộ não con người thì càng tốt, vì bộ não hoạt động tốt hơn nhiều so với mạng thần kinh. Nhưng đầu năm 2023, tôi đã đột ngột thay đổi suy nghĩ của mình.

Con người có thể cố gắng chia sẻ kiến thức nhưng chúng ta làm việc đó rất chậm. Trong tính toán kỹ thuật số, anh đưa mọi thứ về số 1 và số 0, theo đó kiến thức trở thành bất tử. Nó không phụ thuộc vào bất kỳ phần cứng cụ thể nào.

Các mô hình ngôn ngữ lớn có tất cả lượng kiến thức đó, lượng kiến thức nhiều gấp hàng nghìn lần so với những gì con người chúng ta có, với số lượng kết nối ít hơn khoảng 100 lần, điều này cho thấy AI có thuật toán học tập hiệu quả hơn.

Hỏi: Liệu AI có thể tự nhận thức hoặc có ý thức không?

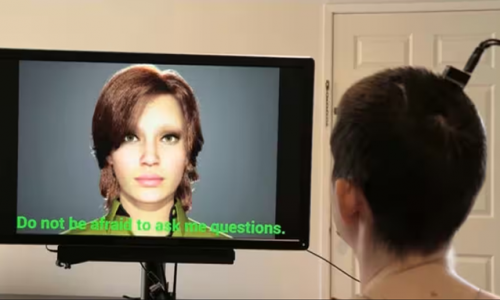

Đáp: Tôi nghĩ các chatbot đa phương thức đã bắt đầu có những trải nghiệm mang tính chủ quan.

Tôi cho rằng suy nghĩ của hầu hết mọi người về mô hình não bộ đều sai. Để tôi cho anh một ví dụ: Giả sử tôi uống quá nhiều rượu, và sáng hôm sau thức dậy nhìn thấy những chú voi hồng nhỏ xíu. Tôi sẽ nghĩ điều đó có nghĩa là hệ thống nhận thức của tôi không hoạt động bình thường.

Bây giờ, giả sử tôi có một chatbot đa phương thức và nó có camera và một cánh tay, nên nó có thể chỉ trỏ, hiểu ngôn ngữ, và đã được huấn luyện. Tôi đặt một lăng kính phía trước camera của chatbot để làm cong các tia sáng, rồi đặt một vật thể ở phía trước nó. Nhưng chatbot không biết về lăng kính. Lúc này tôi nói: “Hãy chỉ vào vật thể,” rồi lại nói, “Không, đó không phải là vật thể. Vật thể ở ngay trước mặt bạn. Tôi đã đặt một lăng kính trước camera của bạn.”

Chatbot sẽ đáp lại, “Ồ, tôi có thấy vật thể đó thực sự ở ngay trước mặt tôi. Nhưng tôi có trải nghiệm chủ quan rằng nó ở đằng kia.” Giờ đây, nếu một chatbot nói điều đó thì tôi nghĩ nó sẽ sử dụng từ “trải nghiệm chủ quan” theo cùng một cách chính xác như con người.

Hỏi: Giáo sư Yann LeCun của Đại học New York ở Mỹ, người đồng đoạt Giải Turing với ông, lại phủ nhận khả năng tri thức hoặc tri giác trong AI.

Đáp: Chúng tôi vẫn là bạn bè, nhưng về điểm này chúng tôi hoàn toàn không đồng ý với nhau. Hầu hết mọi người nghĩ rằng AI không có trải nghiệm chủ quan. Con người chúng ta có một điều đặc biệt, đó là ý thức, trải nghiệm chủ quan, hoặc khả năng tri giác, còn AI thì không có thứ đó. Tôi nghĩ quan điểm đó thật sai lầm.

(Theo nghiencuuquocte.org)