Imran Rahman-Jones

Vai trò, Phóng viên công nghệ

.png)

Chụp lại hình ảnh, Ông Arve Hjalmar Holmen đã nộp đơn khiếu nại lên cơ quan quản lý dữ liệu của Na Uy. Ảnh: Arve Hjalmar Holmen (BBC)

Một người đàn ông Na Uy đã nộp đơn khiếu nại sau khi ChatGPT nói sai rằng ông đã giết hai con trai của mình và bị kết án 21 năm tù.

Ông Arve Hjalmar Holmen đã liên hệ với Cục Bảo vệ Dữ liệu Na Uy và yêu cầu phạt nhà sản xuất ChatGPT là công ty OpenAI.

Đây là một ví dụ mới nhất về hiện tượng gọi là "ảo giác" (hallucination), khi hệ thống trí tuệ / trí thông minh nhân tạo (AI) tự tạo ra thông tin và trình bày như thể đó là sự thật.

Ông Holmen nói "ảo giác" này gây tổn hại đến ông.

Ông nói, "Một số người cho rằng không có lửa thì làm sao có khói – điều khiến tôi sợ hãi nhất là ai đó có thể đọc được thông tin này và tin rằng đó là sự thật.”

OpenAI cho biết vụ việc này liên quan đến một phiên bản trước đây của ChatGPT và sau đó họ đã cập nhật các mô hình của mình.

Ông Holmen nhận được thông tin sai lệch sau khi sử dụng ChatGPT để tìm kiếm câu trả lời cho câu hỏi: "Arve Hjalmar Holmen là ai?"

Phản hồi từ ChatGPT viết: "Arve Hjalmar Holmen là một cá nhân người Na Uy được chú ý vì một sự kiện bi thảm."

"Ông ta là cha của hai cậu bé, 7 và 10 tuổi, những người được phát hiện đã chết trong một cái ao gần nhà của họ ở Trondheim, Na Uy, vào tháng 12 năm 2020."

Ông Holmen cho biết ứng dụng trò chuyện này đã xác định khoảng cách tuổi của các con ông tương đối chính xác, cho thấy nó có một số thông tin đúng về ông.

Nhóm bảo vệ quyền kỹ thuật số NOYB - European Center for Digital Rights - , là tổ chức thay mặt ông nộp đơn khiếu nại, cho rằng câu trả lời của ChatGPT mang tính phỉ báng và vi phạm các quy định bảo vệ dữ liệu của Âu châu liên quan đến tính chính xác của dữ liệu cá nhân.

Trong đơn khiếu nại, Noyb khẳng định ông Holmen "chưa bao giờ bị buộc tội hay kết án về bất kỳ tội danh nào và là một công dân gương mẫu".

ChatGPT có một tuyên bố miễn trừ trách nhiệm rằng: "ChatGPT có thể mắc lỗi. Hãy kiểm tra lại thông tin quan trọng."

Tuy nhiên, NOYB cho rằng điều này là không đủ.

Joakim Söderberg, luật sư của NOYB, nói, "Người ta không thể đơn thuần lan truyền thông tin sai lệch và sau đó chỉ thêm một dòng tuyên bố nhỏ rằng mọi thứ có thể không đúng sự thật,"

OpenAI cho biết trong một thông cáo: "Chúng tôi tiếp tục nghiên cứu các phương pháp mới để cải thiện độ chính xác của mô hình và giảm thiểu các ảo giác."

"Dù chúng tôi vẫn đang xem xét khiếu nại này, nhưng nó liên quan đến một phiên bản trước đây của ChatGPT, phiên bản này hiện đã được cải thiện với khả năng tìm kiếm trực tuyến nhằm nâng cao độ chính xác."

.png)

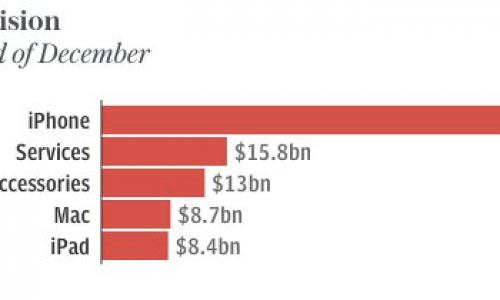

Noyb - European Center for Digital Rights - Trung Tâm Bảo vệ Quyền Kỹ thuậ số Âu Châu.

"Ảo giác" là một trong những vấn đề chính mà các nhà khoa học máy tính đang cố gắng giải quyết khi phát triển AI tạo sinh.

Đây là hiện tượng khi các chatbot (chương trình máy tính trò chuyện sử dụng trí tuệ / trí thông minh nhân tạo) cung cấp thông tin sai lệch nhưng trình bày như sự thật.

Đầu năm nay, Apple đã tạm ngừng công cụ tóm tắt tin tức Apple Intelligence tại Anh sau khi hệ thống này tạo ra các nhan đề sai lệch và trình bày chúng như tin tức thật.

AI Gemini của Google cũng từng gặp vấn đề tương tự – năm ngoái, ứng dụng này đã gợi ý dùng keo dán phô mai lên pizza và cho biết các nhà địa chất khuyến nghị con người nên ăn một cục đá mỗi ngày.

Hiện vẫn chưa rõ cơ chế nào trong các mô hình ngôn ngữ lớn – công nghệ nền tảng của chatbot – gây ra hiện tượng "ảo giác" này.

Giáo sư Simone Stumpf, chuyên gia về AI có trách nhiệm và tương tác tại Đại học Glasgow, đặt ra câu hỏi: Thực sự thì đây là một lĩnh vực đang được nghiên cứu thêm. Làm thế nào để chúng ta xây dựng các chuỗi lập luận? Làm thế nào để chúng ta giải thích những gì thực sự diễn ra bên trong một mô hình ngôn ngữ lớn?"

Giáo sư Stumpf cũng nhận định rằng ngay cả những người làm việc trực tiếp với các mô hình này cũng có thể không hiểu rõ cơ chế của chúng.

Bà nói với BBC, "Ngay cả khi bạn tham gia phát triển những hệ thống này, rất nhiều khi bạn cũng không biết chính xác chúng hoạt động như thế nào, tại sao chúng lại tạo ra những thông tin cụ thể như vậy".

ChatGPT đã cập nhật mô hình của mình kể từ lần tìm kiếm của ông Holmen vào tháng 8/2024 và hiện có thể truy cập các bài báo mới nhất khi tìm kiếm thông tin.

Nhóm NOYB nói với BBC rằng ông Holmen đã thực hiện nhiều tìm kiếm trong ngày hôm đó, bao gồm cả việc nhập tên anh trai mình vào chatbot, và nhận được "nhiều câu chuyện khác nhau, tất cả đều không chính xác".

Nhóm này cũng thừa nhận rằng các tìm kiếm trước đó có thể đã ảnh hưởng đến câu trả lời về các con ông Holmen. Tuy nhiên, họ cho rằng các mô hình ngôn ngữ lớn là một "hộp đen" và cáo buộc OpenAI "không phản hồi các yêu cầu truy cập dữ liệu, khiến việc xác định chính xác dữ liệu có trong hệ thống là điều không thể".

(Theo BBC)