OpenAI lo ngại rằng người dùng có thể bắt đầu phụ thuộc quá nhiều vào chế độ giọng nói giống như con người của ChatGPT, đặc biệt với những người cô đơn, họ có thể xem chatbot này như một người bạn.

Tiết lộ này được đưa ra trong báo cáo vào hôm 29/08 từ OpenAI về quá trình đánh giá an toàn mà công ty này đã tiến hành đối với công cụ AI này.

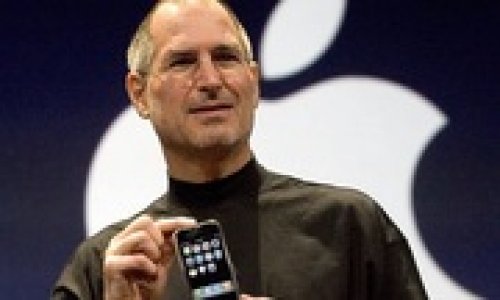

Chế độ giọng nói tiên tiến của ChatGPT nghe rất giống thật. Nó phản hồi theo thời gian thực, có thể điều chỉnh khi bị ngắt lời, tạo ra những âm thanh mà con người tạo ra trong khi trò chuyện như cười hoặc "hmms". Nó cũng có thể đánh giá trạng thái cảm xúc của người nói dựa trên tông giọng của họ.

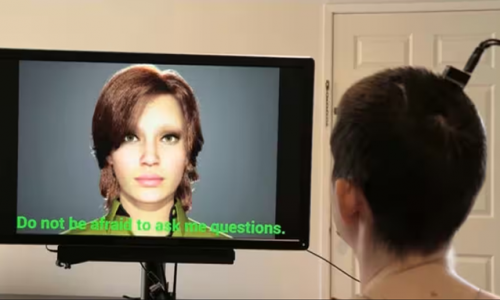

Chỉ vài phút sau khi OpenAI công bố tính năng này tại một sự kiện vào đầu năm nay, nó đã được so sánh với trợ lý kỹ thuật số AI trong bộ phim "Her" năm 2013, người mà nhân vật chính đã yêu, nhưng lại vô cùng đau khổ khi AI thừa nhận "cô ấy" cũng có mối quan hệ với hàng trăm người dùng khác.

Hiện tại, OpenAI dường như lo ngại rằng câu chuyện hư cấu này có vẻ hơi quá gần với thực tế, sau khi công ty cho biết họ đã quan sát thấy người dùng trò chuyện với chế độ giọng nói của ChatGPT bằng ngôn ngữ "thể hiện mối liên kết chung" với công cụ này.

.jpg)

OpenAI lo ngại những người cô đơn có thể bị phụ thuộc về mặt tình cảm với chế độ giọng nói giống con người của chatbot AI.

Cuối cùng, "người dùng có thể hình thành mối quan hệ xã hội với AI, giảm nhu cầu tương tác với con người — có khả năng mang lại lợi ích cho những cá nhân cô đơn nhưng có thể ảnh hưởng đến các mối quan hệ lành mạnh", báo cáo nêu rõ. Báo cáo cũng nói thêm rằng việc nghe thông tin từ một bot có giọng nói giống như con người có thể khiến người dùng tin tưởng công cụ này nhiều hơn mức họ nên tin, vì AI có xu hướng làm sai mọi thứ.

Báo cáo nhấn mạnh một rủi ro lớn liên quan đến trí thông minh nhân tạo: các công ty công nghệ đang chạy đua để nhanh chóng triển khai các công cụ AI mà họ cho rằng có thể đảo lộn cách chúng ta sống, làm việc, giao lưu và tìm kiếm thông tin. Nhưng họ đang làm như vậy trước khi bất kỳ ai thực sự hiểu được những tác động đó là gì. Cũng giống như nhiều tiến bộ công nghệ khác, các công ty thường có một ý tưởng về cách các công cụ của họ có thể và nên được sử dụng, nhưng người dùng lại nghĩ ra rất nhiều ứng dụng tiềm năng khác, thường đi kèm với những hậu quả không mong muốn.

Các chuyên gia cũng bày tỏ mối lo ngại khi một số người đã hình thành những mối quan hệ mà họ mô tả là lãng mạn với chatbot AI.

Liesel Sharabi, Giáo sư Đại học bang Arizona chuyên nghiên cứu về công nghệ và giao tiếp giữa con người, đã trả lời phỏng vấn CNN vào tháng 6 rằng: "Các công ty phải có trách nhiệm rất lớn trong việc thực sự điều hướng điều này theo cách có đạo đức và có trách nhiệm, và hiện tại tất cả vẫn đang trong giai đoạn thử nghiệm". "Tôi lo lắng về những người đang hình thành mối liên hệ thực sự sâu sắc với một công nghệ có thể không tồn tại lâu dài và liên tục phát triển".

OpenAI cho biết tương tác của người dùng với chế độ giọng nói của ChatGPT theo thời gian cũng có thể ảnh hưởng đến những gì được coi là bình thường trong các tương tác xã hội.

Công ty cho biết trong báo cáo: "Các mô hình của chúng tôi có tính tôn trọng, cho phép người dùng ngắt lời và 'cầm mic' bất cứ lúc nào. Mặc dù điều này là bình thường đối với AI, nhưng lại trái với chuẩn mực trong tương tác giữa con người".

Hiện tại, OpenAI cho biết họ cam kết xây dựng AI một cách "an toàn" và có kế hoạch tiếp tục nghiên cứu khả năng "phụ thuộc về mặt cảm xúc" của người dùng vào các công cụ của mình.

(BBT)