.png)

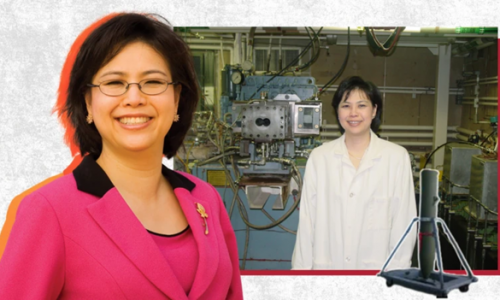

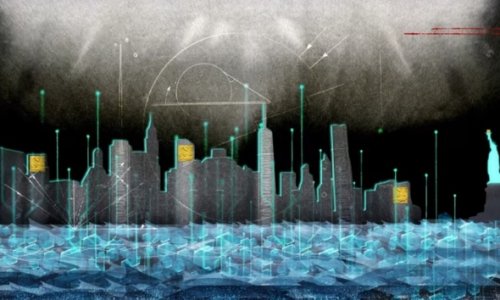

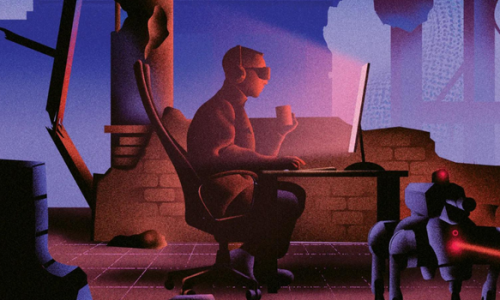

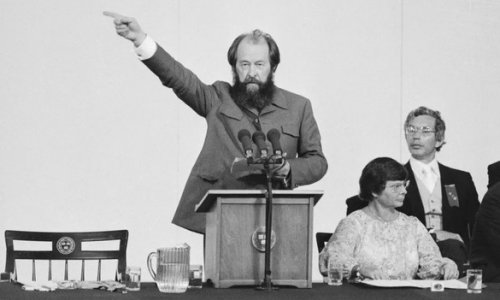

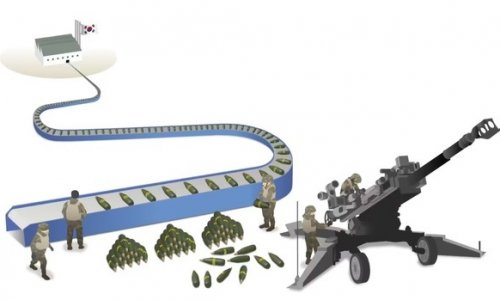

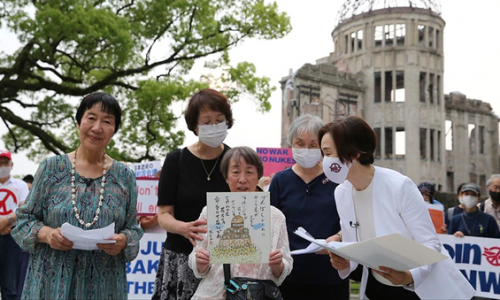

Những kẻ lừa đảo thường gọi điện với thông điệp được thu âm sẵn, sử dụng giọng nói do AI sao chép. Source: Getty / ronstik

Một ngân hàng lớn cảnh báo rằng, hàng triệu người có nguy cơ trở thành mục tiêu của trò lừa đảo giả giọng bằng AI.

Ngân hàng trực tuyến Starling Bank tại Anh cho biết “hàng triệu người” có thể bị lừa bởi những kẻ sử dụng trí tuệ nhân tạo (AI) để sao chép giọng nói.

Ngân hàng này cảnh báo rằng chỉ cần ba giây âm thanh từ một video đăng trên mạng xã hội, kẻ gian có thể dùng AI để tạo ra bản sao giọng nói của bạn.

Sau đó, chúng có thể tiếp cận bạn bè và người thân của bạn để thực hiện các cuộc gọi lừa đảo, yêu cầu chuyển tiền bằng giọng nói đã được sao chép.

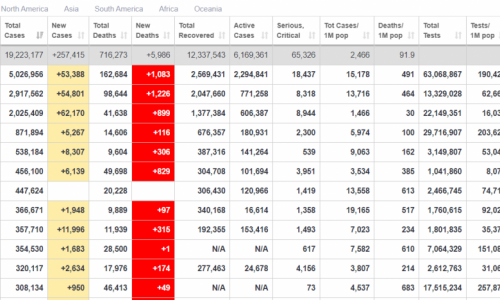

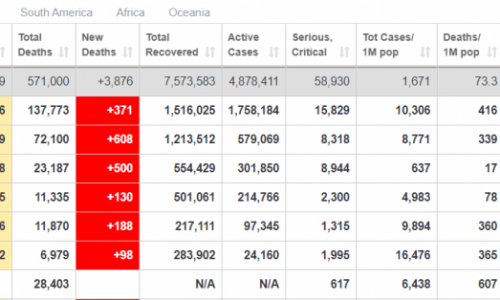

Theo một cuộc khảo sát trên 3.000 người do Starling Bank phối hợp cùng Mortar Research thực hiện vào tháng trước, hơn một phần tư số người được hỏi cho biết họ đã trở thành mục tiêu của một vụ lừa đảo giảgiọng bằng AI trong 12 tháng qua.

Cuộc khảo sát cũng tiết lộ rằng 46% người tham gia không biết rằng có những trò lừa đảo như vậy, và 8% sẽ chuyển tiền theo yêu cầu của bạn bè hoặc thành viên gia đình ngay cả khi họ nghi ngờ tính xác thực của cuộc gọi.

Giám đốc an ninh thông tin của Starling Bank, bà Lisa Grahame, cho biết “Mọi người thường xuyên đăng nội dung trực tuyến có ghi âm giọng nói của bản thân mà không bao giờ nghĩ rằng điều đó sẽ khiến họ dễ trở thành mục tiêu của những kẻ lừa đảo.”

Ngân hàng khuyến khích mọi người thiết lập một “cụm từ an toàn” với những người thân yêu của họ – một cụm từ đơn giản, ngẫu nhiên, dễ nhớ và khác với các mật khẩu khác –để xác minh danh tính qua điện thoại.

Ngân hàng cũng khuyên người dùng không nên chia sẻ cụm từ an toàn qua tin nhắn, vì tin nhắn có thể bị kẻ gian nhìn thấy. Nếu chia sẻ theo cách này, người nhận nên xóa ngay sau khi đọc.

Lừa đảo giả giọng bằng AI: Những điều cần biết

Vào đầu năm nay, ngân hàng NAB đã liệt kê lừa đảo giả giọng bằng AI vào danh sách các thủ đoạn nguy hiểm hàng đầu mà người dân Úc cần cảnh giác trong năm 2024.

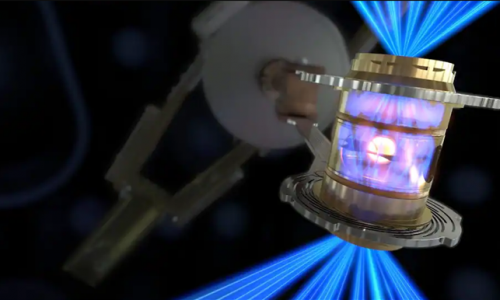

Giáo sư Toby Murray thuộc khoa Khoa học Máy tính và Hệ thống Thông tin của Đại học Melbourne nói với tổ chức vận động vì quyền của người tiêu dùng CHOICE, “Công nghệ nhân bản giọng nói bằng AI cho phép bắt chước giọng của ai đó với độ chính xác cao, và kết quả ngày càng khó phân biệt”

Chỉ cần một vài giây ghi âm giọng nói từ video trên mạng xã hội, kẻ gian có thể tạo ra bản sao giọng nói rất thuyết phục.

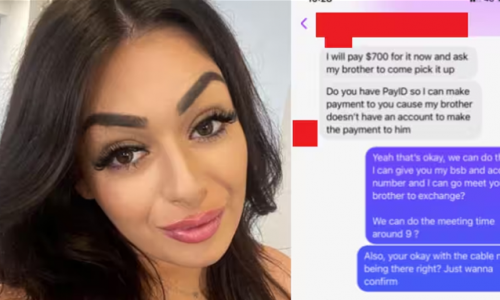

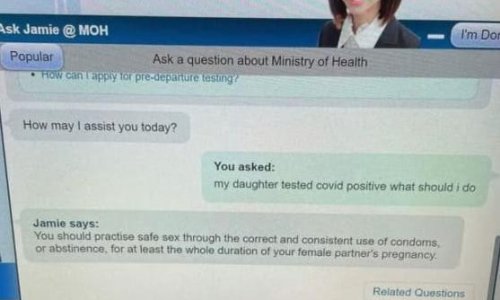

Sau đó, chúng sẽ dùng bản sao này để thực hiện cuộc gọi với thông điệp được thu âm sẵn, giả vờ cần tiền gấp và yêu cầu chuyển tiền qua thẻ quà tặng, tiền điện tử hoặc tài khoản ngân hàng, tương tự như trò lừa đảo “Hi Mum” qua tin nhắn.

Sự phổ biến của các công cụ AI tinh vi đã cung cấp cho bọn tội phạm phương tiện để sao chép giọng nói nhanh chóng với chi phí tương đối thấp.

Chỉ cần tìm kiếm từ khoá “voice cloning” trên Google, bạn sẽ thấy hàng loạt dịch vụ nhân bản giọng nói, một số hứa hẹn chỉ cần vài phút để hoàn thành.

Làm thế nào để bảo vệ giọng nói trước việc bị AI sao chép?

Ông Murray cho biết, một khi đã chia sẻ giọng nói và video cá nhân lên mạng, chúng ta không thể ngăn chặn giọng nói của mình bị sao chép.

Ông nói “Trong thời đại truyền thông xã hội, việc yêu cầu mọi người không đăng video của họ lên mạng là điều vô lý,”

“Cũng như việc bạn khó có thể ngăn người khác tạo tài khoản mạng xã hội giả mạo mình, chúng ta đang bước vào kỷ nguyên mà giọng nói và khuôn mặt có thể bị AI sao chép.”

Tuy nhiên, bạn có thể thiết lập quyền riêng tư cho tài khoản mạng xã hội của mình để chỉ bạn bè và người thân mới có thể nhìn thấy nội dung bạn đăng tải.